ACTU

RTX 3080 : les performances testées

par CBL,

email @CBL_Factor

par CBL,

email @CBL_Factor

L'embargo sur les benchmarks de la RTX 3080 viennent de tomber un peu partout. Chez The Verge, on met des notes aux cartes graphiques et on teste une carte graphique de fin 2020 avec un CPU de début 2017. C'est concept. Chez Clubic, on colle aussi des notes et on tente de rendre les benchs illisibles en collant des textes gris sur un fond bleu marine.

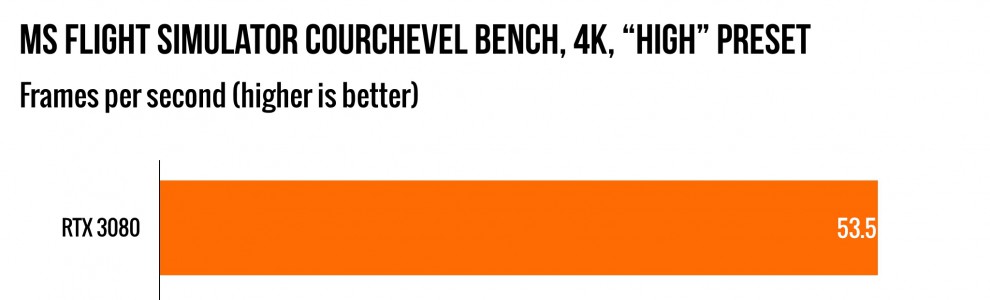

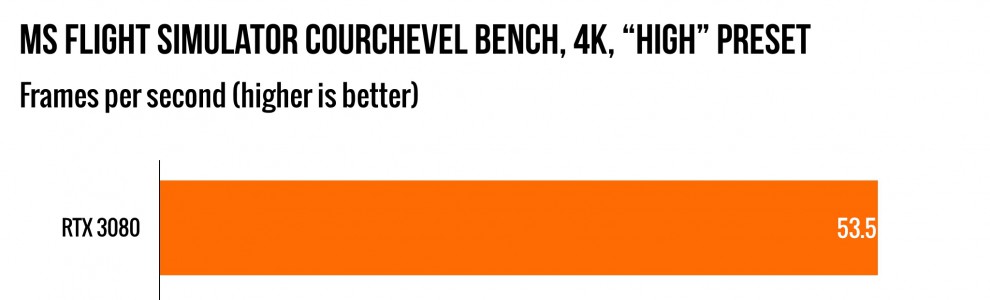

On vous conseille plutôtl'encyclopédie l'article de Tech Power Up qui est super complet mais qui laisse de côté LE jeu PC du moment : Microsoft Flight Simulator 2020. Alors que disent tous ces gens?

Commençons par expliquer un concept souvent mécompris : les goulots d'étranglements. Pour générer une nouvelle image, un jeu doit globalement effectuer trois tâches:

C'est flagrant dans deux cas de figures:

En 1080p, la RTX 3080 est en moyenne 35% plus rapide que la RTX 2080. C'est encore moins dans les jeux très demandeurs en CPU comme Anno 1800. Par contre pour un jeu comme Detroit Become Human le CPU ne fait pas grand chose. Non seulement la logique du jeu ne prend pas beaucoup de temps CPU mais en plus le jeu utilise Vulkan. Donc la RTX 3080 peut librement s'exprimer.

En 1440p, ça commence à être la fête vu que la RTX 3080 est en moyenne 51% plus rapide que la RTX 2080. Mais c'est vraiment en 4K où la RTX 3080 se fait plaisir. Elle enfume la 2080 (environ 66% plus rapide) et la 2080 Ti (environ 31% plus rapide). Elle est même deux fois plus rapide que la 1080 Ti pour ceux qui ont une carte Maxwell. Mise à part quelques rares exceptions, la RTX 3080 fait tourner tous les jeux en 4K@60FPS à condition de ne pas utiliser le ray-tracing. Que ce soit sur Metro Exodus ou sur Battlefield V, activer les effets RTX en 4K fait chuter le framerate de moitié et sous la barre des 60 FPS.

"Mais CBL on s'en fout du 4K. Ca sert à rien de toute façon sur un écran de 32 pouces." Et vous auriez raison. Mais il y a un autre segment du jeu PC qui nécessite des résolutions de taré : la réalité virtuelle. Malheureusement il semble que personne n'ait fait de benchmarks sur Half-Life: Alyx. La seule fois que j'ai vu la VR mentionnée, c'est chez Ars Technica : Elite Dangerous tourne à 120 FPS en détails élevés sur un Valve Index et le super mal optimisé Fallout 4 VR tourne à 100-110 FPS sur le même casque. Donc en plus d'être une carte taillée pour le 4K, la RTX 3080 est aussi taillée pour la VR.

Au niveau du CPU, avoir un CPU Intel ou AMD ne fait pas une grande différence en 4K car vous avez de toute façon un goulot d'étranglement GPU. Mais pour les résolutions inférieures, Intel conserve l'avantage : les jeux actuels continuent de préfèrer des coeurs plus puissants à des coeurs plus nombreux. Tout cette puissance a par contre un prix à savoir une facture EDF en hausse : la RTX 3080 consomme en moyenne 300W en jeu avec des pointes à 350W pour les jeux les plus gourmands. La bonne nouvelle est que le design de la Founder's Edition fait que la RTX 3080 est relativement silencieuse et chauffe moins que la 2080.

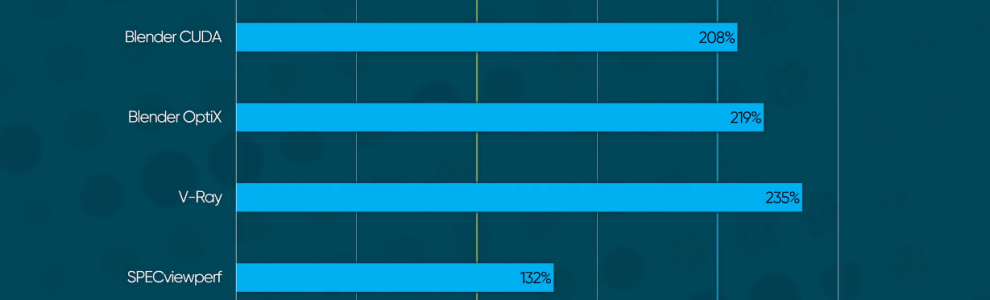

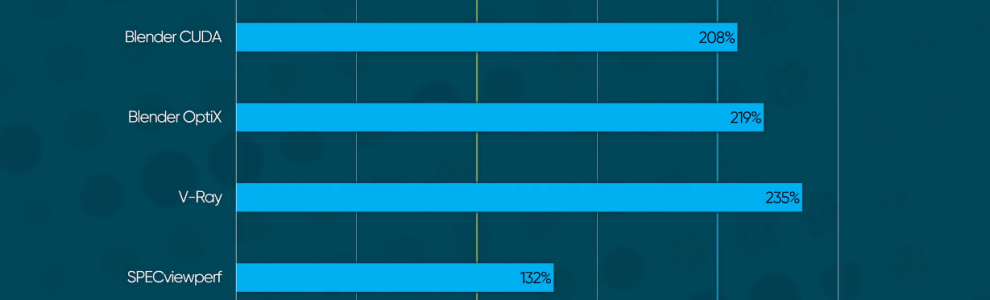

"Bon c'est bien gentil mais dans ton barratin sur les FLOPS, tu nous promettais mieux." Oui et je parlais de puissance théorique. Les jeux vidéo utilisent massivement les shaders mais ils ne font pas que cela. Il y a beaucoup d'autres facteurs à prendre en compte. Pour des applications tirant beaucoup plus partie de la puissance brut, il faut se tourner vers le rendu 3D. Les moteurs de rendu modernes type OTOY utilisent les coeurs CUDA et parfois les coeurs RT (via Optix). Et le résultat est sans appel : la RTX 3080 est deux fois plus rapide que la RTX 2080. Ceci étant dit, le rendu 3D est un peu handicapé par le manque de mémoire vidéo donc les plus fortunés attendront la 3090.

Même combat pour l'apprentissage automatique. Pour de l'anayse d'image, la RTX 3080 est 2x plus rapide que la 2080 avec les coeurs CUDA et 2,6x en utilisant les TensorCores.

Enfin, pour des applications tirant pleinement partie de la puissance brut, il faut se tourner vers les applications qui ne font que du calcul comme par exemple le minage de crypto-monnaie. En minant de l'Etherum, la RTX 3080 arrive à calculer près de 90 millions de fonctions de hashage par seconde contre 54 pour la 2080 Ti et 35 pour la 2080 ce qui est raccord avec le nombre de TFLOPS. Mine de rien (ha ha ha), cela veut dire que pour 700 euros, vous pouvez vous payer un mini-serveur de rendu pour les artistes ou de calcul pour les scientifiques.

Tout celà est bien gentil mais bon courage pour choper une 3080. La carte est en rupture de stock mondial en grande partie à cause des raclures d'Ebay. Nvidia tente d'améliorer la situation en vérifiant manuellement que les commandes sont passées par des humains et pas des bots mais ce devrait être le bordel pendant un bon bout de temps.

On vous conseille plutôt

Commençons par expliquer un concept souvent mécompris : les goulots d'étranglements. Pour générer une nouvelle image, un jeu doit globalement effectuer trois tâches:

- faire tous les calculs liés au comportement du jeu comme l'IA, le traitement des données réseau, les collisions...

- dire à la carte graphique ce qu'elle doit afficher

- utiliser ces informations pour rendre le tout

C'est flagrant dans deux cas de figures:

- les jeux demandant des ressources CPU démesurées (type Supreme Commander)

- les jeux tournant à basse résolution avec une carte graphique haut de gamme

En 1080p, la RTX 3080 est en moyenne 35% plus rapide que la RTX 2080. C'est encore moins dans les jeux très demandeurs en CPU comme Anno 1800. Par contre pour un jeu comme Detroit Become Human le CPU ne fait pas grand chose. Non seulement la logique du jeu ne prend pas beaucoup de temps CPU mais en plus le jeu utilise Vulkan. Donc la RTX 3080 peut librement s'exprimer.

En 1440p, ça commence à être la fête vu que la RTX 3080 est en moyenne 51% plus rapide que la RTX 2080. Mais c'est vraiment en 4K où la RTX 3080 se fait plaisir. Elle enfume la 2080 (environ 66% plus rapide) et la 2080 Ti (environ 31% plus rapide). Elle est même deux fois plus rapide que la 1080 Ti pour ceux qui ont une carte Maxwell. Mise à part quelques rares exceptions, la RTX 3080 fait tourner tous les jeux en 4K@60FPS à condition de ne pas utiliser le ray-tracing. Que ce soit sur Metro Exodus ou sur Battlefield V, activer les effets RTX en 4K fait chuter le framerate de moitié et sous la barre des 60 FPS.

"Mais CBL on s'en fout du 4K. Ca sert à rien de toute façon sur un écran de 32 pouces." Et vous auriez raison. Mais il y a un autre segment du jeu PC qui nécessite des résolutions de taré : la réalité virtuelle. Malheureusement il semble que personne n'ait fait de benchmarks sur Half-Life: Alyx. La seule fois que j'ai vu la VR mentionnée, c'est chez Ars Technica : Elite Dangerous tourne à 120 FPS en détails élevés sur un Valve Index et le super mal optimisé Fallout 4 VR tourne à 100-110 FPS sur le même casque. Donc en plus d'être une carte taillée pour le 4K, la RTX 3080 est aussi taillée pour la VR.

Au niveau du CPU, avoir un CPU Intel ou AMD ne fait pas une grande différence en 4K car vous avez de toute façon un goulot d'étranglement GPU. Mais pour les résolutions inférieures, Intel conserve l'avantage : les jeux actuels continuent de préfèrer des coeurs plus puissants à des coeurs plus nombreux. Tout cette puissance a par contre un prix à savoir une facture EDF en hausse : la RTX 3080 consomme en moyenne 300W en jeu avec des pointes à 350W pour les jeux les plus gourmands. La bonne nouvelle est que le design de la Founder's Edition fait que la RTX 3080 est relativement silencieuse et chauffe moins que la 2080.

"Bon c'est bien gentil mais dans ton barratin sur les FLOPS, tu nous promettais mieux." Oui et je parlais de puissance théorique. Les jeux vidéo utilisent massivement les shaders mais ils ne font pas que cela. Il y a beaucoup d'autres facteurs à prendre en compte. Pour des applications tirant beaucoup plus partie de la puissance brut, il faut se tourner vers le rendu 3D. Les moteurs de rendu modernes type OTOY utilisent les coeurs CUDA et parfois les coeurs RT (via Optix). Et le résultat est sans appel : la RTX 3080 est deux fois plus rapide que la RTX 2080. Ceci étant dit, le rendu 3D est un peu handicapé par le manque de mémoire vidéo donc les plus fortunés attendront la 3090.

Même combat pour l'apprentissage automatique. Pour de l'anayse d'image, la RTX 3080 est 2x plus rapide que la 2080 avec les coeurs CUDA et 2,6x en utilisant les TensorCores.

Enfin, pour des applications tirant pleinement partie de la puissance brut, il faut se tourner vers les applications qui ne font que du calcul comme par exemple le minage de crypto-monnaie. En minant de l'Etherum, la RTX 3080 arrive à calculer près de 90 millions de fonctions de hashage par seconde contre 54 pour la 2080 Ti et 35 pour la 2080 ce qui est raccord avec le nombre de TFLOPS. Mine de rien (ha ha ha), cela veut dire que pour 700 euros, vous pouvez vous payer un mini-serveur de rendu pour les artistes ou de calcul pour les scientifiques.

Tout celà est bien gentil mais bon courage pour choper une 3080. La carte est en rupture de stock mondial en grande partie à cause des raclures d'Ebay. Nvidia tente d'améliorer la situation en vérifiant manuellement que les commandes sont passées par des humains et pas des bots mais ce devrait être le bordel pendant un bon bout de temps.